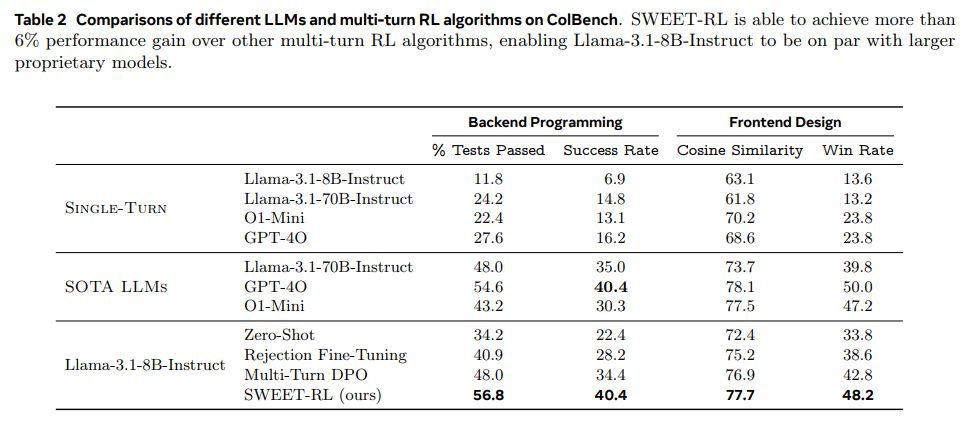

科技媒体 marktechpost 昨日(3 月 23 日)发布博文,报道称 Meta AI 公司携手加州大学伯克利分校,合作推出名为 SWEET-RL 的强化学习框架,并发布了 CollaborativeAgentBench(ColBench)基准测试。

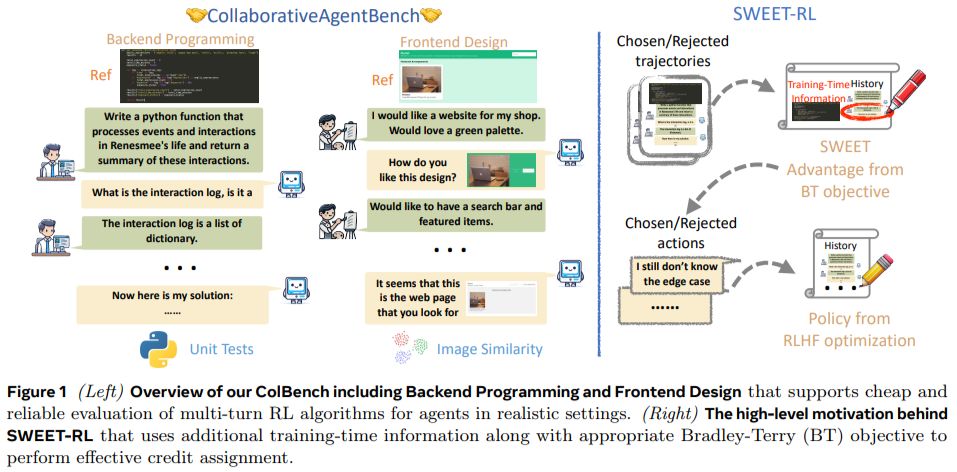

这一创新旨在提升大语言模型(LLMs)在多轮人机协作任务中的表现,特别是在后端编程和前端设计领域。SWEET-RL 通过逐轮优化决策,显著提高了模型的任务完成率,并展示了其在开源模型(如 Llama-3.1-8B)与专有模型(如 GPT-4o)竞争中的潜力。

项目背景

IT之家援引博文介绍,大语言模型正逐渐演变为能够执行复杂任务的自主智能体,但在多轮决策任务中仍面临挑战。

传统训练方法依赖于单轮反馈或模仿高概率行为,无法有效处理长期依赖和累积目标。这导致模型在协作场景中表现不佳,特别是在理解人类意图和多步骤推理方面。

SWEET-RL 的创新之处

SWEET-RL 采用非对称的“演员-评论家”结构,评论家在训练过程中可以访问额外信息(如正确答案),从而更精确地评估演员的决策。

该框架直接建模逐轮的优势函数,简化了信用分配过程,并与 LLMs 的预训练架构更好地对齐。实验结果显示,SWEET-RL 在后端编程任务中通过率提升至 48.0%,前端设计任务的余弦相似度达到 76.9%,显著优于其他多轮强化学习方法。

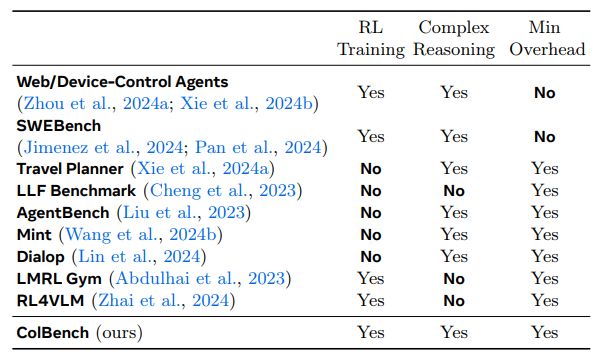

ColBench 基准测试

ColBench 包含超过 10000 个训练任务和 1000 个测试案例,模拟真实的人机协作场景。任务设计涵盖后端编程(如 Python 函数编写)和前端设计(如 HTML 代码生成),并限制每轮交互最多 10 次。