数智化时代正在加速演进,人工智能已成为推动各行各业转型升级的新质生产力。尤其是通用人工智能技术的不断突破,让“人工智能+”的应用场景和范围得到极大拓展,真正步入“以人工智能为新质赋能”的新阶段。

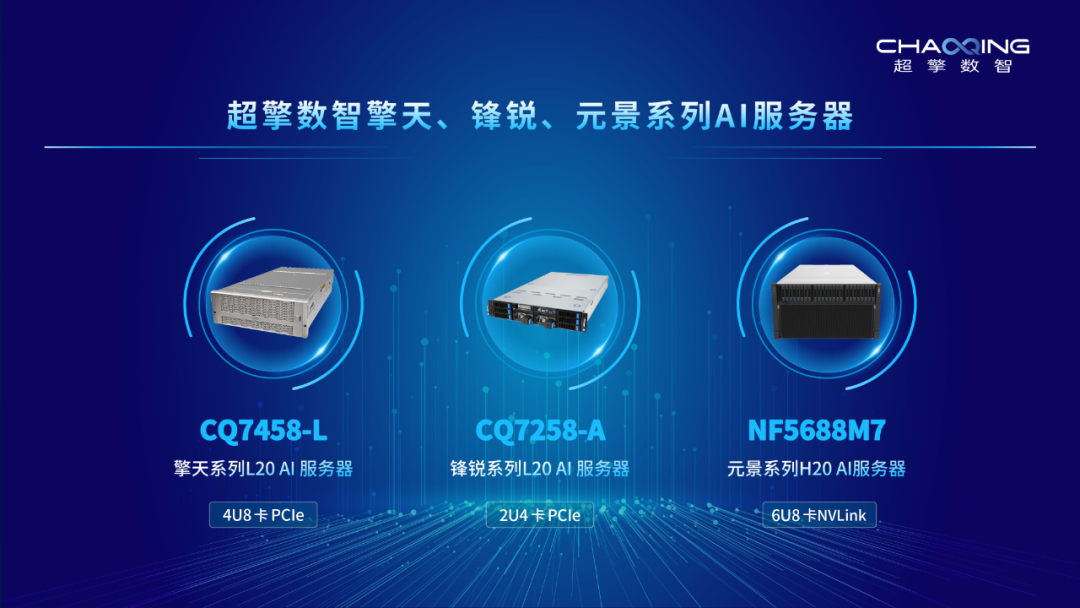

为满足“人工智能+”时代算力基础设施和创新应用快速增长的需求,日前,超擎数智重磅发布全新自研的擎天、锋锐、元景系列AI服务器产品,为大规模数据训练和推理提供强劲性能,帮助AI用户高效构建AI基础设施和应用环境,满足AI场景下的多元算力需求,为AI新质生产力提供强劲引擎。

擎天系列L20 AI服务器,4U8卡PCle

擎天系列L20 AI服务器型号为CQ7458-L,是超擎数智国内首发的 NVIDIA 新一代L20 AI服务器。擎天系列L20 AI服务器基于 Intel 最新Eagle Stream平台,搭载 NVIDIA L20 GPU,4U8卡 PCIe,采用“283”方案设计,搭载2颗Intel第四代CPU,连接8片L20 GPU、2片CX7 400G NDR网卡和1片BlueField-3 2X200G DPU卡,具备业界领先的性能,可满足训练和推理、生成式人工智能、图形视觉计算、视频加速应用等各种AI 业务应用需求。

作为超擎数智国内首发的AI服务器新品,擎天系列L20 AI 服务器性价比出色,在相同的GPU数量下,所需的服务器机头更少,适合千卡到万卡的中型规模GPU部署。

强大性能:采用 Intel 至强可扩展第四代处理器平台,TDP 350W;DDR5 技术+PCIe Gen5 最新技术支撑;PCIe 直通配置低时延打造极致性能;前后 IO 维护兼容设计,具备广泛的适用性,满足多场景应用的高性能需求。

灵活的拓扑方案:CPU-GPU 支持直通及 Switch 方案,最大支持 10 张双宽 GPU 卡;CPU-Switch 可选 X32 或 X16 lane 互联,实现高带宽通信;支持common和performance 等不同 CPU-GPU 互联拓扑,适用更多应用场景。

高可靠性:搭配2颗 PCIe Gen 5 switch,支持单双宽 GPU 卡,适配NVIDIA最新 GPU 方案,专属团队全面支撑用户定制化开发需求,确保系统的高稳定性和可靠性。

锋锐系列L20 AI服务器,2U4卡PCle锋锐系列L20 AI服务器型号为CQ7258-A,是超擎数智国内独家发布的 NVIDIA 新一代L20 GPU服务器。锋锐系列 L20 AI服务器采用 AMD EPYC 9004 处理器,搭载 NVIDIA L20 GPU,2U4卡 PCIe,采用“142”方案设计,搭载一颗 AMD EPYC 9004 处理器,连接4片L20 GPU、2片CX7 400G NDR网卡,专为满足企业AI 基础设施的需求而打造,通过行业领先的GPU、更快的GPU互连及更高带宽结构提供强大的性能,并支持多达4个双槽主动或被动GPU可扩展配置,还可以选择 NVIDIA NVLink Bridge 来实现性能扩展及更高带宽,助力加速AI 和高性能计算 (HPC)工作负载。

锋锐系列AI服务器性能出色,所有GPU直接连接到CPU,无需经过PCIe Switch,配备两张NDR网卡,每张GPU可提供200G 带宽,大大提高工作效率,能够充分满足AI推理、模型微调和高性能计算过程中的强大算力需求。

强大性能:采用 AMD EPYC 9004 处理器提供了高达 64 个核心和 128 个线程,适合处理需要大量并行处理能力的任务,如数据分析、科学模拟和复杂的计算工作负载。支持高速 DDR4 和新兴的 DDR5 内存技术,以及使用八通道内存配置,提供更大的内存带宽和容量,满足内存密集型应用的需求。

应用灵活:L20 GPU配备第四代Tensor Core与第三代 RT Core,支持模型训练、推理、图形视觉处理等多种工作负载。

极高效率:采用CPU直通,无需PCIe Switch即可搭载4张GPU与2张NDR网卡,大大提升系统数据传输效率。

元景系列H20 AI服务器,6U8卡 NVLink元景系列H20 AI服务器型号为NF5688M7,是超擎数智推出的智能算力旗舰新产品。元景系列H20 AI服务器搭载 NVIDIA H20 GPU,6U8卡 NVLink,是基于全新一代 AI 超融合架构平台,面向超大规模数据中心的强劲性能,极致扩展的AI服务器,最强算力密度6U空间内搭载1块 NVIDIA Hopper 架构 HGX-8GPU 模组,系统支持4.0Tbps网络带宽,满足万亿级参数超大模型并行训练需求。

元景系列H20 AI服务器搭载2颗Intel 第四代至强 可扩展处理器(TDP 350W),最高可达4TB系统内存,128TB NVMe高速存储,支持高达12个PCIe Gen5 x16扩展槽位,可灵活支持OCP 3.0、CX7多种智能网卡,构建面向超大模型训练、元宇宙、自然语言理解、推荐、AIGC等场景的最强AI算力平台。

强劲性能:搭载8颗 NVIDIA 最新Hopper架构GPU,2颗Intel 第四代至强 可扩展处理器,集成Transformer引擎,大幅加速GPT大模型训练速度。

极致能效:散热性能极致优化,风道解耦设计提升20%系统能效比;12V和54V N+N冗余电源分离供电设计,减少电源转换损耗;可选支持系统全液冷设计,液冷覆盖率高于80%,PUE<1.15。

领先架构:节点内全PCIe 5.0高速链路,CPU至GPU带宽提升4倍;节点间高速互联扩展,4.0Tbps无阻塞带宽IB/RoCE组网;集群级优化架构设计,GPU: 计算IB: 存储IB=8:8:2。

多元兼容:全模块化设计,一机多芯兼容,灵活配置支持本地和云端部署;支持大规模GPT-3/LLaMA/ChatGLM模型训练和推理;领先支持多样化的SuperPod解决方案,适用AIGC, AI4Science及元宇宙等丰富场景。

丰富的应用场景,满足AI多元算力需求大模型训练

超擎数智擎天、锋锐、元景系列AI服务器可为大规模数据集上训练复杂的 AI 模型提供强劲的算力支持,能够快速执行大规模并行计算,显著缩短模型训练时间,大幅提升大模型训练的性能和效率。

垂类模型训练

超擎数智提供多样化的AI服务器产品方案,满足金融、能源、教育、生物医疗等垂类行业的模型训练或任务开发,以更高的灵活性和适应性,满足特定行业的不同算力需求,实现客户不同应用的效果和可靠性,助力垂类模型应用落地。

推理工作

超擎数智擎天、锋锐、元景系列AI服务器搭载性能和功耗平衡的GPU,提供实时、高精度的计算能力,以卓越的处理速度和能效,可以快速执行优化推理任务,满足大规模的数据分析和处理,确保智能应用的实时响应需求,实现业务高效稳定运行。

科学计算

搭载大容量内存、高性能处理器和GPU,加速气候模拟、物理模拟、天体物理学、蛋白分子研究等复杂计算任务,满足需要大规模数值计算和数据分析的场景。

图形/视觉计算

对于 Omniverse、渲染和 VFX 等图形密集型工作负载,超擎数智擎天、锋锐系列AI服务器搭载L20 GPU,提供强大的视觉计算功能,可以轻松支持图形、视觉计算任务。

擎天、锋锐、元景系列AI服务器系列产品的重磅推出,是超擎数智深化“All in AI”发展战略,坚持创新、追求极致,全面构建人工智能新质生产力的又一重要里程碑。作为领先的人工智能整体解决方案提供商,超擎数智将紧抓算力时代新机遇,以“人工智能+”,做好“新”和“质”协同发展,助力行业和用户加速形成新质生产力,探索“人工智能+”深层次应用场景,为构建万物互联的数智世界赋智赋能。