对比英伟达Vera Rubin计算托盘与华为超节点(如Atlas 950/960 SuperPoD)的优劣势,需从架构设计、性能表现、能效比、生态兼容性、适用场景等核心维度展开,并结合两者的技术路线差异(英伟达“硬件极致优化” vs 华为“系统创新突围”)进行分析。

一、英伟达Vera Rubin计算托盘:硬件极致优化的“AI超级计算机构建块”

英伟达Vera Rubin计算托盘是其Vera Rubin AI超级计算机的核心组件,定位为“无电缆、无软管的完全重新设计计算单元”,旨在通过六芯片协同(Vera CPU+Rubin GPU+BlueField-4 DPU+ConnectX-9网卡)与极致互联,实现单节点性能的突破,支撑超大规模AI训练与推理。

1. 核心优势

硬件性能极致:单节点算力与互联带宽领先

Vera Rubin计算托盘集成了2颗Vera CPU(88核Arm架构)+4颗Rubin GPU(第三代Transformer引擎,FP4推理算力50 PFLOPS/颗),单托盘算力达100 PFLOPS(FP4),相当于上一代Blackwell架构的5倍。

互联方面,采用NVLink 6交换机(单机架带宽260 TB/s)与ConnectX-9 SuperNIC(800Gb/s网络),实现72颗GPU像单颗超级GPU般协同工作,彻底消除跨节点通信瓶颈。这种“硬件级协同”使Vera Rubin在大模型训练(如万亿参数模型)与高并发推理(如生成式AI)中具备显著性能优势。

能效比突破:45℃温水液冷与无电缆设计

采用100%全液冷+45℃温水冷却技术,通过“自然冷却覆盖全年95%时间”(冷却液45℃进水,50-55℃排出,无需冷水机组),使PUE(能源使用效率)逼近1.08(行业理论极限)。无电缆设计不仅将组装时间从数小时缩短至5分钟,更减少热阻带来的额外能耗,散热效率提升18倍。

生态成熟:CUDA生态与全球头部客户支持

英伟达CUDA生态已覆盖90%以上AI开发场景,支持PyTorch、TensorFlow等主流框架,合作伙伴包括AWS、微软、谷歌云等全球头部云服务商,以及OpenAI、Anthropic等AI巨头。Vera Rubin已获微软Fairwater AI超级工厂、xAI Colossus集群等规模化部署,生态壁垒显著。

2. 核心劣势

成本极高:单节点价格昂贵

Vera Rubin计算托盘作为“定制化AI超级计算机组件”,单节点价格预计远超100万美元(参考英伟达DGX SuperPOD单价),且需配套800Gb/s网络交换机、液冷基础设施等,整体部署成本极高,仅适合全球头部科技企业或云服务商。

灵活性不足:物理设计封闭

采用“完全重新设计”的物理架构(无电缆、定制基板),虽提升了性能,但也限制了硬件升级灵活性(如无法单独更换GPU或CPU)。对于中小企业或需要“按需扩展”的场景,这种封闭设计可能不适用。

供应链风险:依赖台积电先进制程

Vera Rubin的核心组件(如Rubin GPU、Vera CPU)均采用台积电3nm N3P工艺,依赖单一供应链。若未来台积电产能受限或地缘政治因素影响,可能导致交付延迟。

二、华为超节点Atlas 950/960 SuperPoD:系统创新突围的“AI基础设施平台”

华为超节点是其“超节点+集群”战略的核心产品,定位为“物理上多机、逻辑上单机”的AI基础设施平台,旨在通过自研灵衢协议(UnifiedBus)与系统级优化,解决大模型训练的“内存墙”与“通信瓶颈”,支撑全场景AI应用。

1. 核心优势

系统级性能:超节点规模与互联效率领先

华为超节点(如Atlas 950 SuperPoD)支持8192张昇腾950DT卡,通过灵衢2.0协议实现“全对等互联”(384颗昇腾NPU+192颗鲲鹏CPU全互联),单跳时延低于200纳秒,带宽高达392 GB/s,时延较InfiniBand降低62%,带宽利用率达98.7%。这种“系统级互联”使超节点在万亿参数模型训练(如盘古Ultra MoE 7180亿参数)中,通信损耗控制在5%以内(英伟达方案通常牺牲30%算力处理通信),性能显著优于传统集群。

能效比优势:存算一体与风冷/液冷混合部署

昇腾芯片采用存算一体设计(内存与计算单元间距缩短至微米级),使千亿参数模型训练能耗降低40%(ResNet-50测试中,每瓦性能达英伟达H20的89%)。此外,支持风冷/液冷混合部署(如Atlas 850企业级风冷超节点),降低对液冷基础设施的依赖,适合中小企业或老旧数据中心改造。

生态开放:灵衢协议与自主可控

华为通过开放灵衢2.0技术规范(类似安卓开源),构建了“芯片-服务器-光模块”的完整生态链,合作伙伴包括硅基流动、科大讯飞等国内厂商。昇腾芯片已实现7nm工艺自主可控(避免依赖台积电),且支持国产操作系统(如欧拉)与框架(如MindSpore),适合对“自主可控”有需求的客户(如金融、政府)。

2. 核心劣势

单节点性能不足:落后于英伟达Vera Rubin

华为超节点的单节点(如Atlas 950 SuperPoD)算力约300 PFLOPS(FP4),虽高于英伟达DGX SuperPOD,但低于Vera Rubin计算托盘的100 PFLOPS/托盘(注:Vera Rubin超节点规模更大,如NVL144算力达3.6 EFLOPS)。对于单节点极致性能需求(如超大规模模型推理),华为方案可能不如英伟达。

生态成熟度不足:CUDA生态兼容性有限

华为昇腾生态(MindSpore、CANN)虽已覆盖1000+ AI模型,但与CUDA生态(PyTorch、TensorFlow)的兼容性仍有差距。部分国外框架(如PyTorch)需通过MindSpore Lite或CANN适配层运行,可能影响开发效率。

应用场景限制:侧重全场景AI,而非极致训练

华为超节点的设计目标是“全场景AI”(训练+推理+边缘),而非像Vera Rubin那样侧重极致训练性能。对于需要“超大规模分布式训练”(如万亿参数模型)的场景,华为方案可能需要更多节点协同,而英伟达Vera Rubin可通过单节点或少数节点实现。

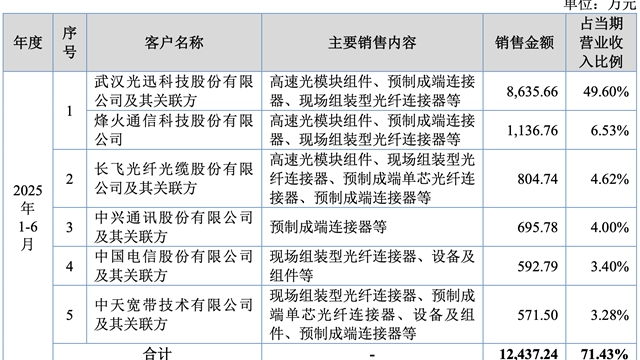

三、两者核心差异总结

英伟达Vera Rubin计算托盘

技术路线:硬件极致优化(六芯片协同、极致互联)

核心优势:单节点性能强、能效比高、生态成熟

核心劣势:成本高、灵活性不足、供应链风险

适用场景:超大规模AI训练(如万亿参数模型)、高并发推理

华为超节点(Atlas 950/960 SuperPoD)

技术路线:系统创新突围(超节点、灵衢协议、存算一体)

核心优势:系统级性能优、能效比高、自主可控、生态开放

核心劣势:单节点性能不足、生态成熟度低、应用场景限制

适应场景:全场景AI(训练+推理+边缘)、中小企业、自主可控

四、结论:选择建议

若需“极致单节点性能”(如超大规模模型训练、高并发推理):选择英伟达Vera Rubin计算托盘,其单节点算力与互联带宽领先,适合全球头部科技企业或云服务商。

若需“系统级优化与自主可控”(如全场景AI、中小企业、老旧数据中心改造):选择华为超节点,其系统级互联与存算一体设计能显著降低通信损耗与能耗,且支持自主可控,适合国内企业或对“安全”有需求的客户。

总体来看,英伟达Vera Rubin是“硬件性能的巅峰”,而华为超节点是“系统创新的典范”,两者分别代表了AI基础设施的两种发展方向。