科技媒体 marktechpost 昨日(5 月 29 日)发布博文,报道称苹果公司携手杜克大学,提出交错推理(Interleaved Reasoning)的全新强化学习(Reinforcement learning,RL)方法,进一步提升大语言模型的推理能力。

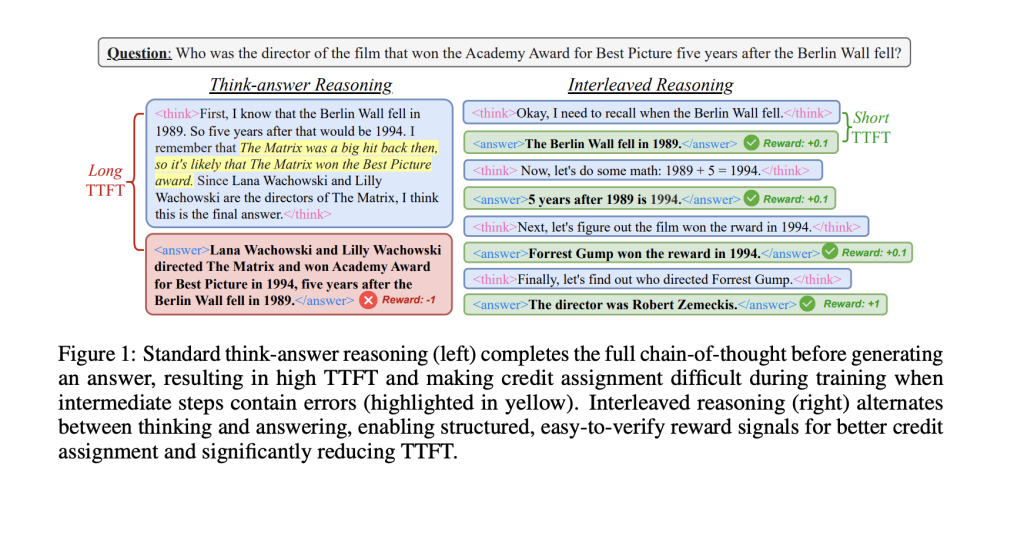

主流大语言模型在处理多步复杂问题时,常采用“先思考后回答”的长链式推理方式。然而,这种方法存在两大痛点:一是响应时间过长,难以满足实时交互需求;二是早期推理步骤出错可能导致最终答案偏差。

研究人员指出,与人类在对话中随时分享部分想法不同,模型往往等到推理全部完成才输出结果,导致效率不高。

苹果公司携手杜克大学,研发了交错推理技术,让模型在推理过程中交替进行内部思考和输出中间答案(sub-answer),从而提升速度与实用性。

交错推理基于强化学习(RL)框架,采用特殊的训练模板,包含

研究团队设计了基于规则的奖励机制,包括格式、最终准确率和条件性中间准确率,确保模型注重整体正确性。

测试中,交错推理在 Qwen2.5 模型(1.5B 和 7B 参数)上表现优异,响应速度提升超 80%,准确率提高高达 19.3%。

此外,该方法仅在问答(QA)和逻辑数据集上训练,却能在 MATH、GPQA、MMLU 等更具挑战性的基准测试中展现强大泛化能力。