本文版权为《邮电设计技术》所有,如需转载请联系《邮电设计技术》编辑部

摘 要:针对移动场景下深度学习模型训练加速问题,首次提出高速移动场景下模型训练4种处理流程,设计端—边—云协同的深度学习模型训练加速方案。搭建模型训练时延优化模型,将训练加速问题转化为多目标受限条件下时延最优解问题。基于麻雀觅食与反捕食行为的启发式优化算法,选择最优模型训练卸载策略,为用户提供训练服务并给出最优卸载量。实验表明,端—边—云协同的训练加速方案可降低模型训练时延。

关键词:模型训练加速;端—边—云协同;麻雀优化算法

doi:10.12045/j.issn.1007-3043.2025.12.014

引言

深度学习是机器学习的重要分支,通过构建多层神经网络,使机器能够模拟人类处理多种类型数据的能力,完成认知层面的复杂任务。目前,深度学习已成为人工智能领域的研究重点和主流方向,被广泛应用于计算机视觉、自然语言处理等多个领域。然而,随着模型规模、数据量的增长及任务要求的多元化,大规模神经网络模型的训练面临着新的挑战。例如,AmoebaNet、NASNet、GPT-3模型因其参数量庞大,传统的集中式训练难以满足其实时性需求。

在图像识别领域,深度学习模型的训练方法主要有2种。一是将深度学习模型部署在云端数据中心,移动设备将收集的图像数据上传至云端,由云端完成模型的训练,实现图像识别。二是利用边缘计算技术,将用于图像识别的深度学习模型部署在多接入边缘计算(MEC)节点,由MEC节点负责模型的训练。

然而,第1种方法存在数据传输时延大的问题,大量图像数据经广域网传至远端云数据中心,使深度学习模型训练耗时多。第2种方法虽能减少图像数据从移动设备传至MEC节点的时延,但MEC节点计算与存储能力有限,训练高精度深度学习模型性能不佳。此外,因MEC节点覆盖范围有限,移动场景下模型训练需考虑任务迁移问题。因此,协同MEC节点及移动设备资源进行任务最优卸载处理成为关注焦点,目前主要有以下2种方法。

a)基于能耗敏感的任务最优卸载方案。该方案以降低能耗为目标,选择最优的MEC节点进行任务卸载,,如文献[7]提出基于Lyapunov优化的在线能耗优化算法,可满足动态任务下的能耗最优。

b)基于时延敏感的任务最优卸载方法。该方法旨在最小化用户任务处理的时延。文献[10]提出启发式算法来求解混合整数线性规划(MILP)模型;而在文献[11]提出迭代算法,将问题分成3个子问题,以交替优化方法结合内凸逼近框架的方式解决该问题,从而降低时延。

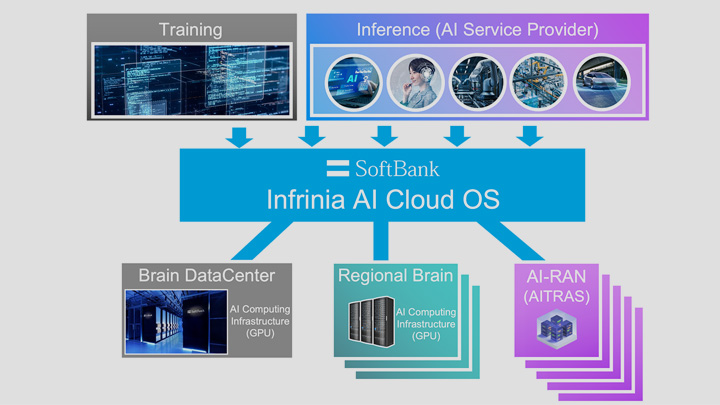

此外,智能手机、无人机等移动端设备受其能量供给的限制,在进行深度学习模型训练时,能耗也是关键的考虑因素。为解决深度学习模型训练方法的问题,本文结合边缘计算技术与云计算技术,构建移动场景下端—边—云协同的深度学习模型训练加速系统架构。通过引入模型分割技术,将端—边—云协同训练建模为在终端能耗、训练时延受限条件下,基于训练时延最小的任务最优卸载问题,实现训练加速。

本文的主要贡献有以下3点。

a)首次分4类场景提出高速移动场景下深度学习模型训练的业务流程,在终端能耗、模型训练时延受限的情况下,综合考虑通信、计算等因素,联合优化任务卸载和任务迁移,设计基于时延最优的深度学习模型训练加速方案,并给出了最优的模型分割的切割点,实现模型训练加速。

b)设计了麻雀优化算法,解决了受限条件下最优解的问题。

c)对模型进行了实验,结果显示在资源受限情况下,本文设计的基于端—边—云协同模型训练时延优化方案相比端—云协同方案、端—边协同方案及端—边—云随机方案,模型训练时延分别降低45%、20%和50%以上。