近日,字节跳动正式发布基于以太网极致优化的 GPU Scale-up 互联技术白皮书,推出 EthLink 的创新网络方案,旨在为 AI 集群提供低延迟、高带宽的高速互联传输,满足 AI 应用对 GPU 之间高效通信的需求。

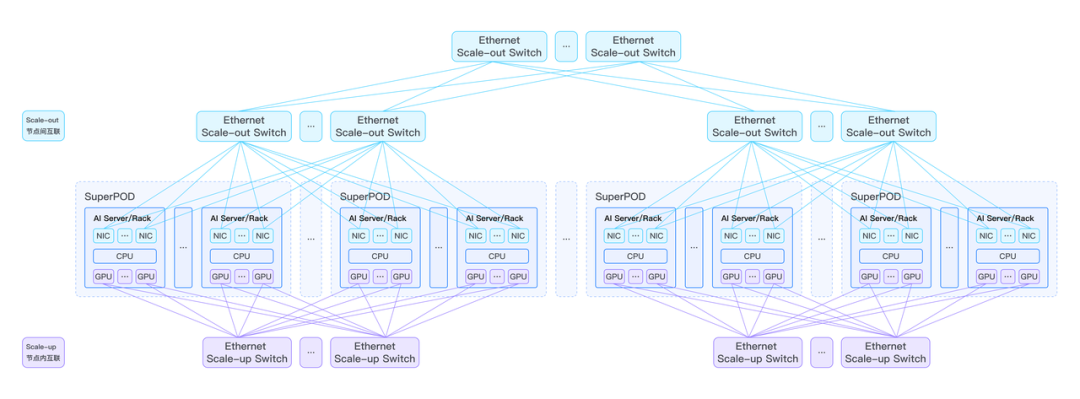

随着 LLM 的参数规模和算力需求呈指数级增长,构建超大规模的 GPU 集群已成为行业共识。在 GPU 万卡集群中,存在着 Scale-up 和 Scale-out 两种互联域,分别负责节点内和节点间的高效数据传输。其中,Scale-up 互联域尤为关键,它要求在单台服务器和 AI Rack 内实现 8 卡及以上 GPU 的高带宽、低时延互联,为模型的张量并行(TP)和专家并行(EP)提供支持。

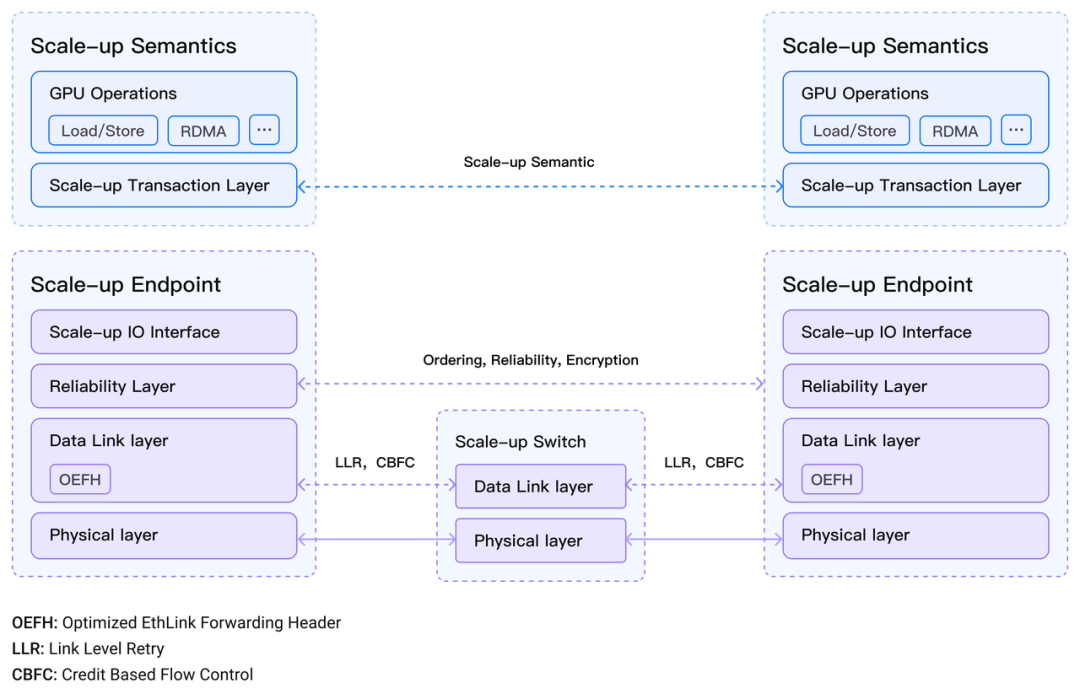

在此背景下,字节跳动提出的 EthLink 方案基于原生以太网进行了极致优化,具备独特的技术优势。该方案允许 GPU 通过 Load/Store 内存语义执行同步操作,实现小块数据的高效传输,适用于对数据传输时延敏感的应用场景;GPU 还能通过 RDMA 消息语义执行异步操作,完成大块数据的快速传输,满足带宽需求大、对时延不敏感的数据应用。

与传统的 Scale-up 互联技术相比,以太网在构建 AI 网络架构方面具有显著优势,包括超高速链路、超大容量交换机、成熟的生态系统以及易于操作的运维体系。尽管多个行业组织已在 AI 网络技术开发方面展开探索,但基于以太网极致优化的 AI Scale-up 互联体系在业界一直处于空白状态。字节跳动的 EthLink 方案填补了这一空白,为 GPU 超节点提供了全新的高速互联通道。

展望未来,字节跳动计划联合产业合作伙伴,共同构建基于以太网的 Scale-up 网络生态,进一步完善 EthLink 技术体系。

字节跳动发布的 EthLink 方案及白皮书,将为 AI 行业的发展注入新的活力。随着相关技术的不断完善和生态系统的逐步建立,AI 应用的性能和效率将得到进一步提升,为通用人工智能的实现奠定更加坚实的基础。