随着大模型技术的飞速发展,多模态智能(即同时理解图像和文字的AI)也迎来了突破。然而,性能表现优异的视觉-语言模型(Vision-Language Models,VLMs),尤其是推理能力强劲的VLMs,普遍存在参数膨胀的问题,中兴通讯受到DeepSeek R1-Zero的启发,推出了Curr-ReFT (Curriculum Reinforcement Fine-Tuning)训练范式,为轻量化的VLMs训练成为推理模型带来了优秀的训练思路。

从启示到创新:Curr-ReFT的诞生

DeepSeek R1-Zero通过“组相对策略优化(Group Relative Policy Optimization, GRPO)”显著提升了大语言模型在复杂推理任务中的表现,展示了模型基于相对响应自我改进的潜力。中兴通讯深度借鉴其理念,结合多模态任务需求,提出了面向小模型后训练优化的Curr-ReFT范式。

Curr-ReFT训练范式从复现R1-Zero在多模态数学数据上的训练起步,发现基础能力提升有限。为解决这一瓶颈,中兴通讯大胆创新,将原本依赖有监督微调的训练流程,全面转向以强化学习为核心的方式,实现在计算机视觉(CV)、多模态任务中的全流程重塑,有效突破“Superficial Pattern Matching(表面模式匹配)”问题。

进一步针对轻量VLM在能力提升上遭遇“Brick Wall(瓶颈墙)”的难题,Curr-ReFT引入“课程式强化学习”策略,通过由易到难、循序渐进的三阶段任务设计,帮助模型逐步激发推理潜能。同时,结合基于拒绝采样的高质量微调机制,实现对模型能力的持续优化。

Curr-ReFT训练范式:重塑轻量化VLM训练的两大核心技术

1. 课程强化学习——循序渐进,攻克难题Curr-ReFT借鉴了课堂教学中 “由易到难”的教学理念,将复杂任务拆分为三个阶段,逐步提升模型的能力:

·第一阶段:二元决策学习,视觉启蒙模型从最简单的任务入手,仅需回答“是”或“否”,快速建立基础的视觉理解和简单推理能力。例如,AI模型能够判断“这是苹果吗?”

·第二阶段:多项选择学习,认知跃迁

随后模型进入选择题阶段,需要从多个选项中挑选正确答案,这一阶段既考验决策能力,也帮助模型学会分辨细节。通过锻炼观察力和细节分析,AI模型升级到会分析“水果里哪个最大?“

·第三阶段:开放式回答,思维觉醒 最终,模型将面对开放性问题,需要根据图像和文字信息自由作答。这时,模型的综合推理能力得到充分锻炼,最终能描述"这幅画讲的是什么故事"。

这一层层递进的奖励机制确保了模型能够稳步提升,逐步适应越来越复杂的任务,而不会因为过早接触难题而出现训练不稳定的情况。

2. 拒绝样本自我改进——精挑细选,持续自我优化为了在提升复杂推理能力的同时不损失模型的基本语言技能,中兴通讯还采用了基于拒绝采样的自我改进机制。

·首先,我们利用先进的GPT-4-O作为奖励模型,对模型生成的回答进行全方位评分(包括准确性、逻辑性、格式和流畅度),只有评分超过85分的回答才被挑选出来。

·接着,这些高质量样本组成一个精编数据集, 这些高分答案成为模型自我学习的参考,通过不断修正错误、优化表现,模型能力持续提升。

这种方法确保模型在不断进步的同时,始终保持扎实的基础能力,避免了因过拟合某些简单任务而影响整体表现。

Curr-ReFT实战验证:小模型,大能量

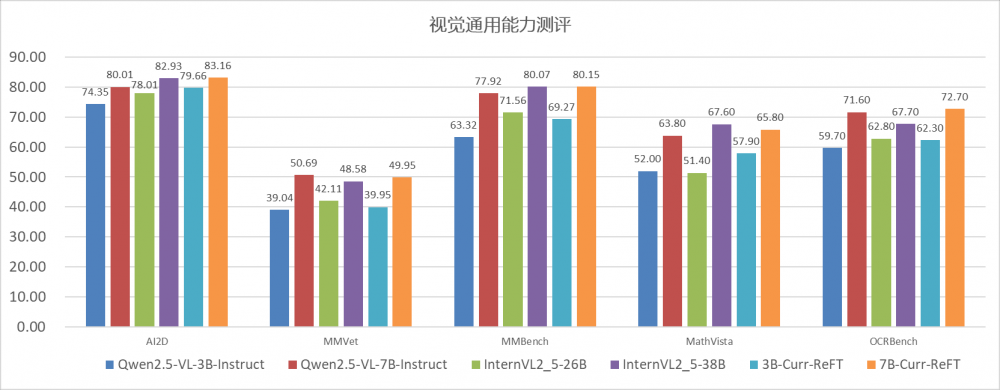

为了全面评估Curr-ReFT后训练方法的效果,我们选取了Qwen2.5-VL-3B和Qwen2.5-VL-7B两个基础模型进行验证。实验结果显示,Curr-ReFT在这两个模型上的表现均显著超越了原有基线,甚至在多个公开基准测试中超越了更大规模的26B(InternVL-26B)和32B(Llava-Next-32B)模型。

·推理能力跃升:Curr-ReFT-3B模型在AI2D数学推理测试中准确率达83%,相比原模型的74%提升显著,甚至超越了多项任务中26B(InternVL-26B)和32B(Llava-Next-32B)的大模型表现。

·泛化能力增强:在Qwen2.5-VL-7B基础上,Curr-ReFT进一步带来性能跃迁。视觉检测准确率从89.8%提升至92.2%,分类任务准确率从71.5%提升至73.1%。在关键基准测试中也取得显著突破(MMVet从29.95%提升至36.78%,MathVista从58.6%提升至92.2%)。

这一系列数据充分证明,Curr-ReFT不仅适配小模型、低算力场景,更具备跨模型、跨任务的通用适应能力。

技术价值全面释放:小模型,大场景

中兴通讯自主研发的Curr-ReFT训练范式,凭借其核心优势,为小型视觉语言模型在各类视觉文本任务中提供了坚实保障,具体亮点包括:

·领先技术:中兴通讯自主研发的Curr-ReFT训练范式,使小型VLMs在各类视觉文本任务中展现出卓越的推理和泛化能力。

·高效易用:该技术采用通俗易懂的分阶段训练和拒绝采样策略,即使在资源有限的环境下,也能实现稳定、快速的模型优化。

·广泛应用场景:无论是智能终端、边缘计算平台还是智算中心,中兴通讯的这项创新均能为客户提供高效、低成本的VLMs解决方案。

携手创新,智绘未来

中兴通讯始终致力于前沿技术的持续探索与突破,将Curr-ReFT这一创新训练范式深度集成至AIS训推平台,不仅大幅简化了轻量化VLM的训练流程,更显著提升了小模型的推理与泛化能力。未来,中兴通讯将携手生态伙伴,共同拓展视觉语言智能的新边界,赋能千行百业迈向更高效、更普惠的智能新时代。

开源下载链接:

代码:https://github.com/ding523/Curr_REFT

数据:https://huggingface.co/datasets/ZTE-AIM/Curr-ReFT-data

模型权重:https://huggingface.co/ZTE-AIM/3B-Curr-ReFT