端侧AI的发展将生成式AI推向纵深

端侧AI是指在终端设备上进行的轻型AI模型应用。由于整个AI的过程都在设备端,不需要连接云端,具有速度快、功耗小、成本低、私密数据等隐私安全有保障等诸多优点。

对于AI大模型而言,虽然训练单个模型会消耗大量资源,但模型每年往往仅需训练几次,而推理则是随着日活用户数量及其使用频率的增加而增加,规模远高于训练,导致在云端推理成本极高,生成式AI规模化拓展将难以持续。要实现AI的规模化扩展并发挥其最大潜能,需要根据不同场景和需求分配AI计算在云和端的工作负载。基于成本、能耗、可靠性和时延、隐私和安全、个性化服务等考虑,终端侧AI能力是赋能混合AI并让生成式AI实现规模化扩展的关键。

1. 相较云侧AI,端侧AI的优势凸显

端侧AI具有低延时、高可靠性、低成本、更利于保护隐私和数据安全等显著优势。

当生成式AI调用对于云的需求达到高峰期时,会产生大量排队等待和高时延,甚至可能出现拒绝服务的情况。端侧AI由于数据的存储计算在本地,响应速度更快,且不会出现与云端链接时网络不稳定、甚至断线的情况,可靠性高。

通过终端独立运行以及云-端协同承担计算负载,可大大降低云端算力需求及能耗成本。将一些处理从云端转移到边缘终端可减轻云端AI基础设施的压力并减少开支,促进AI的应用和推广。

较云侧AI,端侧AI更有助于保护用户隐私和数据安全。端侧AI数据的存储计算等都在本地,避免了传到云端可能带来的数据安全问题,对于个人,更有利于保障个人隐私,对于企业,更有利于保护企业的数据安全。

2. 端侧AI的发展推动AI端云协同

端侧AI的发展离不开AI模型技术和终端技术发展。生成式AI模型通过多种“瘦身”方式正在变小,同时终端侧硬件处理能力持续提升,端侧AI落地的软硬件基础逐步夯实。在降本与安全的双重考量下,AI部署在逐渐从云侧走向端侧,终端和云端协同工作分流AI计算工作负载的端云混合模式或将成为主流部署方案。AI大模型的压缩和端侧推理框架的轻量化,加上边缘算力的跃升,实现大模型在边缘-端侧部署、加速AI与智能终端融合的核心技术条件目前已基本就绪。

随着模型的小型化和终端硬件技术的突破,未来每台手机、PC都将是AI终端,这将带来全新的用户体验。

手机作为使用频率最高,使用时间最长的电子产品,已经成为链接智能汽车、PC、耳机以及其他智能终端的中枢,植入AI大模型后能成为真正的个人智能助理。 对于手机用户来说,本地数据更具安全和隐私优势,对于智能助理的训练更加精确。手机中的AI大模型,可以打破各APP之间的壁垒,实现跨APP相互调用,使得AI手机具有人格化、记忆、感知和管理能力,能够触发主动服务。

AI手机有望成为个人智能助理,为手机行业带来更多创新。目前已经上市的一些AI手机如谷歌Pixel 8及Pixel 8 Pro,具有智能助手、生成式AI图片与音频编辑等功能;三星Galaxy S24,有实时通话语音翻译、AI搜索等功能;德国电信&高通&Brain.AI的T Phone,摒弃了传统的App界面,完全通过AI聊天来满足各种使用需求;小米14/14Pro搭载相关大模型,无需联网,可本地端实现AI画图、智能问答、AI写作等。

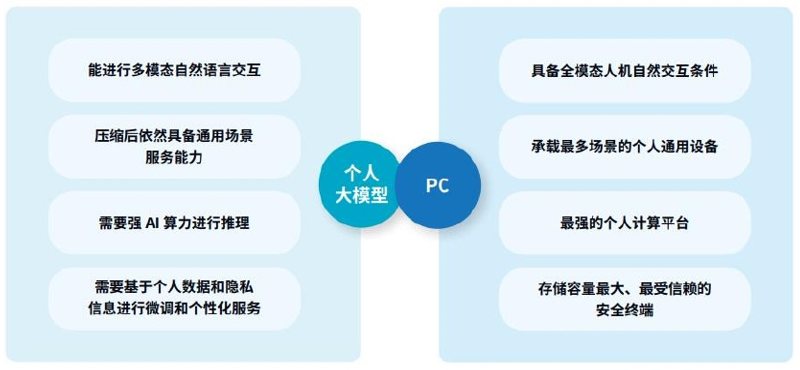

AI PC在人机交互方面有天然优势,拥有全模态的交互方式.能承载生活娱乐、工作、学习等多个场景,拥有大容量的本地安全存储,适合大模型本地部署以及隐私保护,并且,PC能实现强算力与便携性的平衡,是大模型实时推理和高性能计算的更为理想的平台。根据IDC与联想联合发布的白皮书《AIPC产业(中国)白皮书》预测,AIPC将成为终端、边缘计算和云技术的颠覆性混合体,有望在“AI+”终端中最先爆发。

资料来源:《AIPC产业(中国)白皮书》

23年10月, “英特尔on技术创新大会2023”官宣将在今年正式发布面向下一代的AI PC的英特尔酷睿Ultra处理器Meteor Lake ,以加速“AI PC”时代的到来。 此外,英特尔提出“AI PC加速计划”,宣布将为软件合作伙伴提供工程软件和资源,以在2025年前实现为超过1亿台PC实现人工智能特性。

端侧AI的技术日益成熟

1. 端侧AI模型发展迅速,性能水平直追云侧

在模型侧,轻量化移动模型发展迅速,软件层面已实现对大模型进行量化、剪枝、蒸馏,轻量化、小型化以适应移动端场景,结合稀疏计算等方式降低对边缘端侧算力需求。Stable Diffusion等参数超过10亿的模型已能够在手机上运行,且性能和精确度达到与云端处理类似的水平,未来拥有100亿或更多参数的生成式AI模型将能够在终端上运行。如谷歌2023年起相继发布GeminiNano(1.8B/3.25B)、Gemma(2B/7B)等轻量化模型;Meta推出Llama2、MistralAI推出Mixtral8x-7B等开源模型,引领移动模型轻量化发展。

2. 终端硬件突飞猛进,已具搭载大模型能力

端侧PC/Phone的AI能力主要在于搭载了相关的AI芯片。近年来端侧AI芯片算力性能快速提升,为端侧大模型落地做好准备。目前,高通、联发科、英特尔、AMD等龙头芯片厂商都相继推出了能跑十亿甚至百亿量级大模型的终端AI芯片。

2023年10月,高通发布了两款支持端侧运行百亿大模型的芯片——面向PC的骁龙XElite和面向手机的骁龙8Gen3。高通骁龙XElite支持在终端本地运行130亿参数大模型,能以30Tokens/s的速度在终端运行70亿参数的Llama-2模型。高通骁龙8Gen3支持在终端运行100亿大模型。运行70亿参数大模型时,每秒可生成20个token,运行StableDiffusion时,创作图像只需0.6秒。

英特尔第14代酷睿Ultra 其搭载的GPU、NPU、CPU都可以承载AI算力,支持端侧无网运行Llama2-7B。AMD推出内置RyzenAI引擎的锐龙8040系列系列处理器,相较前一代7040,算力大幅提升的同时,在Llama2和视觉模型方面,性能提升多达40%。

端侧AI的发展对电信运营商的影响深远

随着轻量模型性能不断强大、端侧芯片算力不断提升,大模型部署于本地终端成为大势所趋。IDC预测,2024年AI手机出货量将达到1.7亿部,占全球智能手机出货量的15%。英特尔预计全球今年将交付4000万台AI PC,明年将交付6000万台,预估2025年底AI PC在全球PC市场中占比将超过20%; AI赋能有望带来手机、PC、手表等智能可穿戴设备、平板、XR等各类数码产品的换机热潮,而更广泛AIoT(AIoT:人工智能物联网=AI人工智能+IoT物联网)智能也有望在大模型加持下迎来全面升级。终端技术和产品的变革,将会对运营商带来显著的影响。

流量格局的改变。原本集中在云端的AI计算需求将部分转移到终端,导致云流量下降,终端流量上升。由于流量结构的变化,运营商需要适应新的流量格局,调整网络资源配置,优化流量调度策略,降低网络延迟,提升网络QoS,以提升网络性能和用户体验。

运营成本的下降。一方面,算力上云端算力被边缘计算分流,这将减少云端算力的压力和能源功耗,能够降低运营的成本。另一方面,从运维的角度看,端侧AI可以帮助电信运营商提升自动化网络管理和维护任务能力,减少人工干预,也将降低运营的成本。

云侧需求的下降。端侧AI的普及可能会降低云端的价值,使云端更多成为一个简单的存储和计算资源提供者。一些云业务产品将会受到影响,如云电脑、云主机、云游戏等,运营商在技术策略上需要提升云产品的AI能力,使得产品与AI PC/AI PHONE的能力相当或领先。在市场策略上要降低云产品的资费,提升云产品的竞争力。

端云协同催生新业务模式。本地AI应用将快速发展,例如本地语音识别、图像识别、AR/VR等,运营商可以抓住机遇开发新的AI应用和服务。如:提供本地AI模型的训练和部署服务、开发基于本地AI的垂直行业应用、提供本地AI安全和隐私保护解决方案等。端侧AI可以帮助电信运营商开发新的边缘服务,例如AR/VR、物联网、自动驾驶等,创造新的收入来源。

推动5G网络建设。大模型本地部署需要更强大的网络连接,如AIoT的发展,将带动高带宽低时延广连接的5G网络的发展。电信运营商可以加快5G、5G-A网络的建设,为大模型本地部署提供良好的网络基础。

大模型本地部署于终端对运营商是一次机遇和挑战并存的变革。需要加强对端侧AI技术的研发投入,提升自身技术实力。与终端设备厂商、软件厂商等合作伙伴展开合作,构建端侧AI的生态体系。积极探索端侧在各领域的应用场景,开发创新型AI应用和服务。制定合理的端侧AI商业模式。

本文作者

刘敬东

战略发展研究所

二级分析师