8月23日,IBM研究中心发布了一款新型模拟AI芯片,在语音识别和转录等自然语言处理AI任务上,其能源效率较传统芯片提升约14倍,相关论文已刊发于国际顶刊Nature。

据介绍,这款芯片的设计灵感来源于人脑,可以在14nm芯片上集成3500万PCM。IBM研发团队在此芯片上进行了语音识别和转录实验,在保障准确率的前提下,速度和能效均有很大提升。

一、利用PCM存储数据,模拟芯片解决AI技术高能耗问题

AI相关技术在飞速发展的同时,也面临着能源消耗的问题。为了提升能源效率,IBM来自世界各地实验室的研究人员共同研发了这款模拟AI芯片。据称,在两个AI推理实验中,该芯片都像同类数字芯片一样可靠地执行任务,但其完成任务的速度更快,能耗更低。

IBM称,其研究人员一直都在深耕模拟AI芯片领域。2021年,其团队就发布了一款名为Fusion的模拟芯片,利用PCM设备的存储能力和物理属性,更高效地实现人工神经网络。

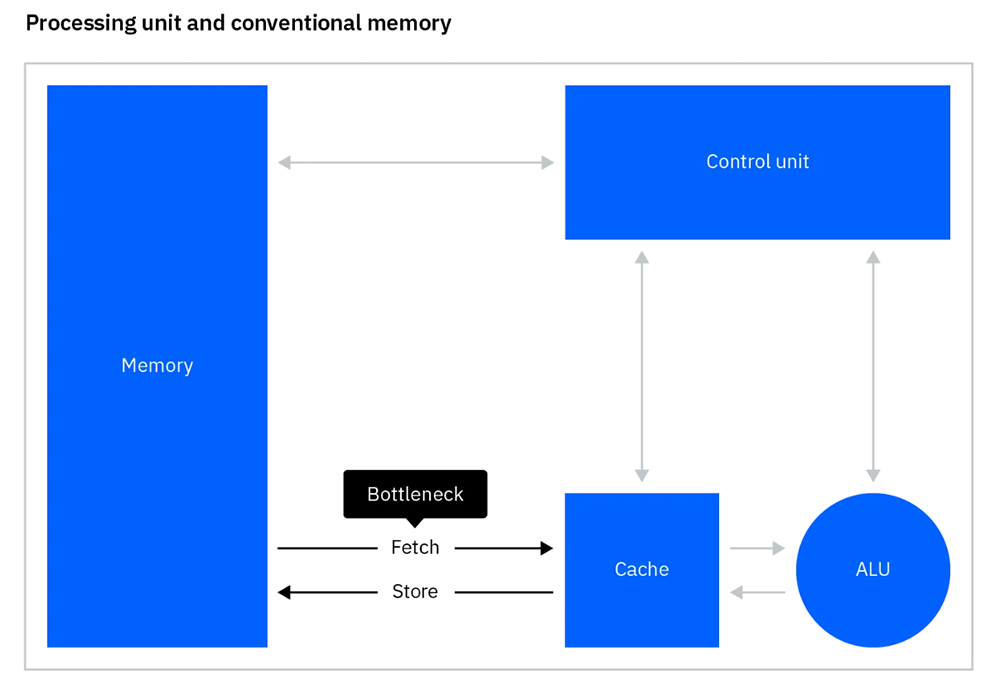

传统计算机基于冯·诺依曼结构——一种将程序指令存储器和数据存储器合并在一起的电脑设计概念结构,每次计算都将数据从DRAM(动态随机存取存储器 )内存传输到CPU,导致工作速度受到实际限制,永远无法实现CPU的真正计算能力,这被称为“冯·诺依曼瓶颈”。

▲当每次计算将数据从 DRAM 内存传输到 CPU 时,传统计算机就会出现瓶颈(图源:IBM官网)

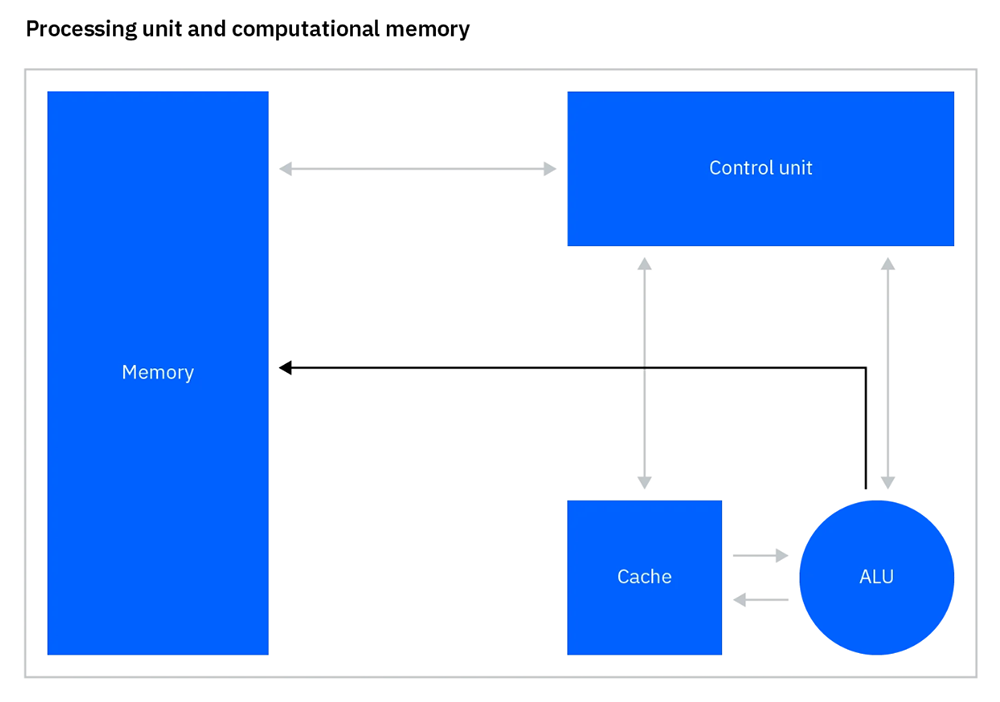

通过利用PCM设备的物理特性,模拟芯片可以克服冯·诺依曼瓶颈,在存储数据的同一位置执行计算。由于没有数据移动,它可以在很短的时间内执行任务,并且消耗的能源更少。

▲模拟芯片通过在存储数据的地方执行计算来克服瓶颈(图源:IBM官网)

例如,将64位数据从DRAM移动到CPU会消耗1-2nJ(纳焦)能量,而在PCM设备上执行只需消耗1-100fJ(飞焦),是前者的1万至200万分之一。当扩展到数十亿次操作时,所节省的能源是巨大的。此外,当设备不活动时,PCM不会消耗电力,即使断电数据也将保留10年。

二、采用全新设计方式,14nm芯片可编码3500万个PCM

虽然IBM早在两年前便以研发出了模拟芯片,并尝试将其用于提升AI计算性能,但Fusion芯片一次只能访问一个PCM设备,对速度和能效的提升并不显著。

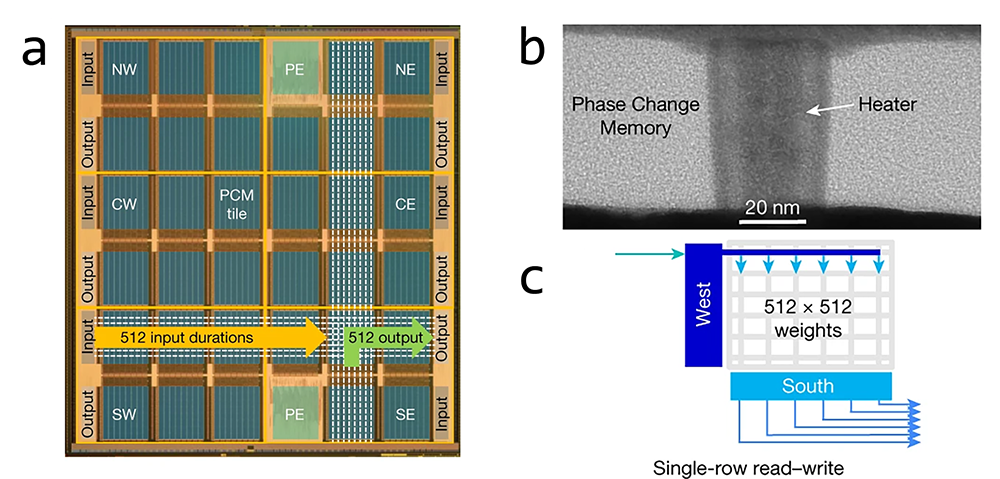

IBM本次发布的这款芯片采用了新的设计方式,利用34个大型PCM阵列,结合了数模转换输入、模拟外围电路、模数转换输出和大规模并行二维网格路由。每个14nm芯片上可编码3500万个PCM,在每权重对应2-PCMs的方案中,可容纳1700万个参数。将这些芯片组合在一起,便能够像数字芯片一样有效地处理真实AI用例的实验。

▲IBM模拟AI芯片的显微照片(图源:论文插图)

上图中,图a显示了芯片的显微照片,突出显示了34个PCM阵列模块的2D网格,每个模块都有自己的512×2,048 PCM交叉阵列。PCM器件集成在14nm前端电路上方的后端布线中(图b),可通过电脉冲调整窄底电极上晶体相(高导电性)和非晶相(高电阻性)材料的相对体积来编码模拟电导状态。对PCM器件进行编程时采用并行编程方案(图c),这样同一行中的所有512个权值都会同时更新。

该研发团队采用的方法是优化主导深度学习计算的MAC(乘积累加运算)。通过读取电阻式NVM(非易失性存储器)设备阵列的行,然后沿列收集电流,团队证明可以在存储器内执行MAC,无需在芯片的存储器和计算区域之间或跨芯片移动权重。

三、精确度不减,语音识别速度提升7倍、大模型运行能效提升14倍

为了验证芯片的有效性,该团队设计了两个实验对其进行测试。他们从MLPerf中选择了两个神经网络模型,分别是语音唤醒和语音转文本模型。MLPerf由斯坦福、哈佛等顶尖学术机构发起成立的,权威性最大、影响力最广的国际AI性能基准测试。

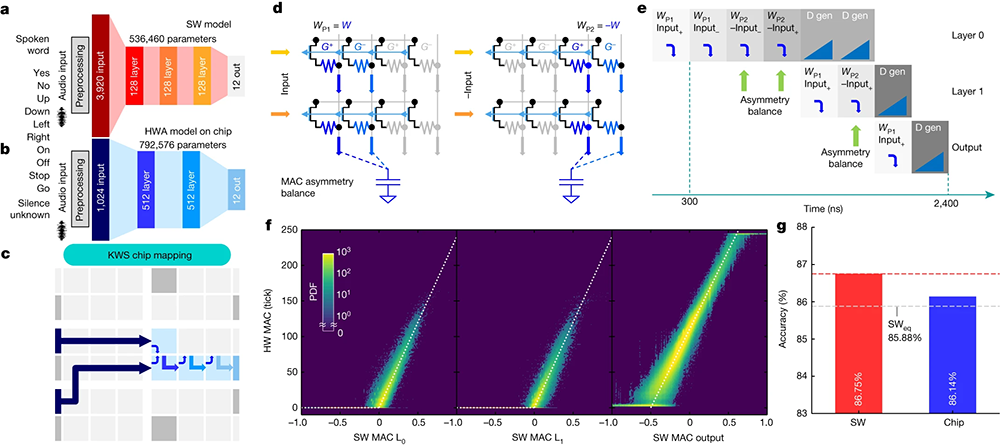

第一个实验围绕关键词语音检测展开。该团队提出了一种卷积神经网络架构,并在包含12个关键字的谷歌语音命令数据集上进行训练。团队采用了架构更简单的FC(全连接)网络结构,最终达到了86.14%的识别精度,且提交速度比MLPerf目前最佳情况快7倍。该模型使用硬件感知训练在GPU上进行训练,然后部署在团队的模拟AI芯片上。

▲端到端语音唤醒任务相关图表(图源:论文插图)

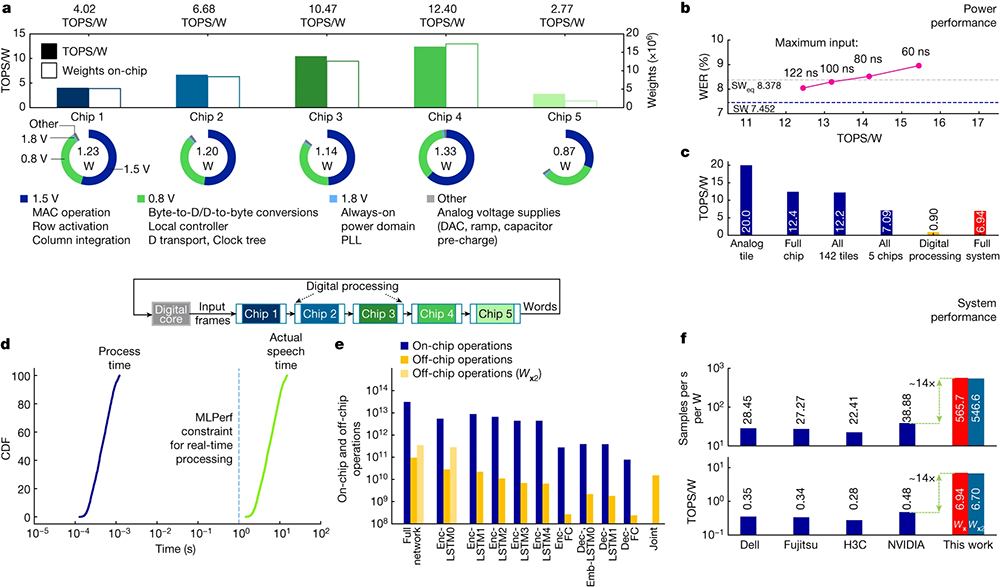

第二个实验围绕语音转文本展开,规模更大。团队使用5个模拟AI芯片组合在一起,运行RNN-T(循环神经网络转换器)模型,以逐个字母地转录语音内容。该系统包含5个芯片上1.4亿个PCM设备的4500万个权重,能够采集人们说话的音频并以非常接近数字硬件设置的精度进行转录。该实验最终达到9.258%的单词错误率,能量效率达6.704TOPS/W(万亿次操作每秒/瓦),比MLPerf目前最佳能效提高了14倍。

▲模拟AI芯片在RNN-T模型上表现出的性能相关图表(图源:论文插图)

与第一个实验不同,这个实验并不完全是端到端的,这意味着它确实需要一些片外数字计算。IBM称,这里涉及的额外计算很少,如果在芯片上实现,最终的能效仍然高于当今市场上的产品。

结语:模拟AI芯片能否成为下一个趋势

继2021年推出第一款模拟芯片Fusion后,IBM于近日发布了专攻AI的模拟芯片,速度、能效均比传统数字芯片大幅提升,准确率也保持高水准。

传统芯片受制于“冯·诺依曼瓶颈”,而模拟芯片可以打破这一桎梏,为AI技术带来新的生命力。未来,模拟芯片市场能否得到进一步发展,我们会持续关注。